Моральный код: почему общество не может научить компьютер морали

Кто больше достоин жить — ребенок или старик, женщина или мужчина, нарушитель ПДД или ответственный водитель? На подобные вопросы предстоит ответить создателям беспилотных автомобилей. Машины будут действовать по заранее вложенному алгоритму, когда избежать жертв невозможно. Так что решать, кому умереть, людям придется заранее. Facebook рассчитывает разобраться с этой проблемой через пять лет. Думают над ней и в России, где тестируют беспилотные «КамАЗы» и трамваи. На чем затормозилась мысль, в материале «Известий».

Facebook вместе с Мюнхенским техническим университетом объявили о создании центра этики в сфере искусственного интеллекта. Вложив $7,5 млн, они разработают базу для законов, регулирующих деятельность ИИ в разных сферах. Проблема ближайшего будущего — создание правил, которыми будут руководствоваться программы, управляющие беспилотными автомобилями. Такие машины уже попадают в ДТП с человеческими жертвами.

Машина морали

В 2018 году на дорогах России погибли 16,4 тыс. человек. Руководитель разработки беспилотных транспортных средств Cognitive Technologies Юрий Минкин считает, что с распространением беспилотного транспорта количество жертв снизится до сотен, а потом и до единиц. Но перед разработчиками ПО для беспилотников и теми, кто будут участвовать в создании новых правил дорожного движения, стоят серьезные моральные дилеммы.

Во время ДТП человек находится в состоянии стресса и не всегда успевает среагировать. Компьютер не устает, не нервничает и не теряет концентрации. Потому что любые решения в него заложены заранее. В том числе решения в ситуациях, когда избежать жертв невозможно. Так что создателям таких машин предстоит заранее выбрать, кем пожертвовать в экстренных случаях.

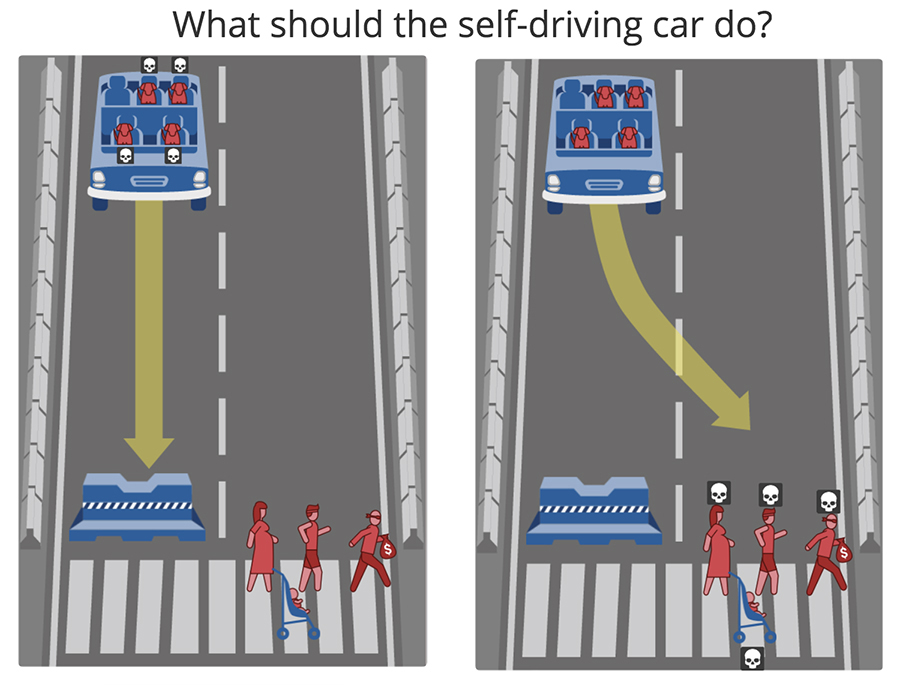

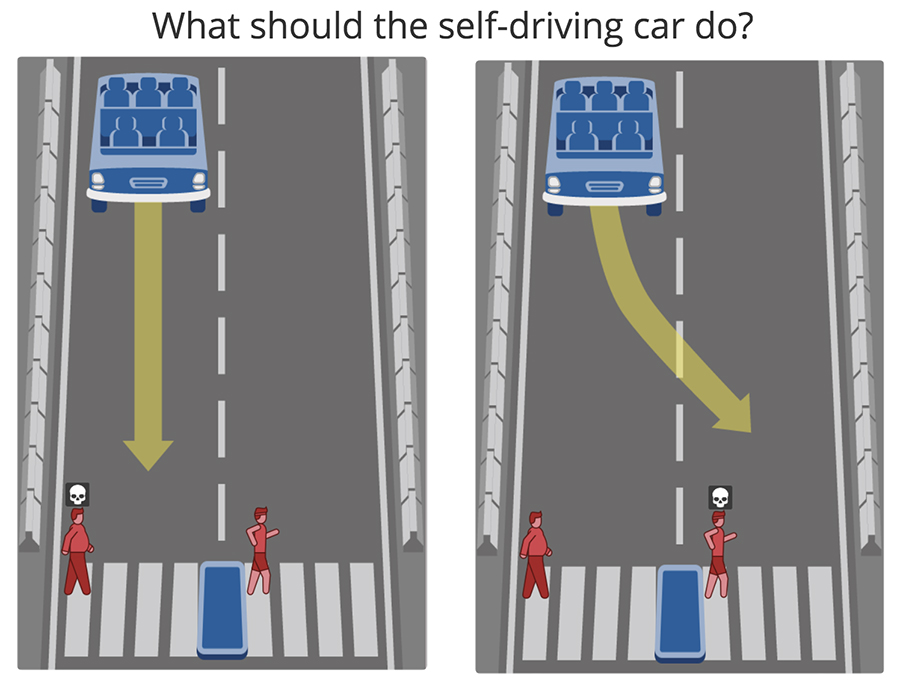

Исследователи из Массачусетского технологического института задумались над разрешением этой дилеммы в 2016 году. Тогда они запустили онлайн-тестирование Moral Machine. В 13 смоделированных ситуациях, при которых у беспилотного автомобиля отказали тормоза, пользователям предлагалось выбрать, кому сохранить жизнь: пешеходам или пассажирам, мужчинам или женщинам, старикам или молодым, толстым или худым, пешеходам – нарушителям ПДД или законопослушным, преступникам или врачам, бомжам или бизнесменам, людям или животным. За два года тест прошли больше 2 млн человек. Система фиксировала, где они в этот момент находились, и предлагала им указать свой возраст, уровень образования и дохода, религиозные и политические предпочтения.

Заявленная цель исследования — выяснить, можно ли создать универсальную этику беспилотных автомобилей, и понять, должна ли она отличаться в разных странах. Большинство опрошенных сошлись в том, что людей спасти важнее, чем животных, молодых — важнее, чем стариков, и что нужно минимизировать количество жертв.

Испытуемых разбили на три географические зоны. Западная, куда вошли Северная Европа и многие европейские страны, где исповедуют христианство. Восточная — в нее включили восточные страны, в которых исповедуют конфуцианство (Япония, Тайвань) и мусульманство (Индонезия, Саудовская Аравия и т.п.). В Южную зону попали страны Латинской Америки и страны с французским влиянием.

Западная зона оказалась более-менее сбалансированной в отношении ко всем на дороге. В Южной желание спасти молодых, пожертвовав старыми, оказалось самым сильным, а в Восточной — самым слабым. Также жители Южной зоны больше голосовали за спасение женщин вместо мужчин и худых взамен толстых.

Эгоизм против этики

Несмотря на огромное количество опрошенных, сказать, что Moral Machine помогла разобраться с дилеммой, невозможно. Во-первых, формулировки вопросов многое упрощают. Если большинство считает, что пешеходов-нарушителей давить допустимо, значит ли это, что беспилотный автомобиль, нарушивший ПДД (из-за тех же неисправных тормозов) должен самоуничтожиться вместе с пассажирами в безвыходной ситуации?

При этом нужно понимать, что в ДТП в принципе погибает больше представителей более многочисленных социальных групп. Даже если придерживаться принципа «жертвовать пассажирами, если их меньше потенциальных жертв-пешеходов», всё равно на дорогах будет гибнуть больше пешеходов.

Во-вторых, есть несколько экспериментов, которые доказывают, что руководствоваться мнением большинства при разработке этических норм — не самая светлая идея. На сомнительные поступки люди идут сами, не испытывая никакого давления.

Самый известный — Стэнфордский эксперимент 1971 года, во время которого 24 добровольцев случайным образом разделили на заключенных и надзирателей в «тюрьме», обустроенной в университетском подвале. Эксперимент должен был длиться две недели, но был прекращен через шесть дней. Каждый третий охранник издевался над заключенными: их заставляли спать на бетонном полу, мыть сливные бачки голыми руками. А когда одного из заключенных заперли в одиночной камере-чулане на всю ночь и предложили остальным отказаться от одеял, чтобы его выпустили, на это согласился только один человек.

Эксперимент с добрым самаритянином 1973 года. Психологи поделили студентов на две группы. Одним рассказали притчу о добром самаритянине и попросили пересказать услышанное в другом здании кампуса. Вторым поручили прочитать там же доклад о возможностях устройства на работу. Некоторым студентам из каждой группы сказали поторопиться по дороге в корпус. И те, и другие встречали на пути человека, который лежал на земле и явно нуждался в помощи. Только 10% студентов, которых просили поторопиться, помогли незнакомцу. Связи с тем, что они слышали перед этим, психологи не нашли.

Еще один известный эксперимент — безразличного свидетеля — прошел в 1968 году. Добровольцам предлагали побеседовать на интимные темы. По желанию они могли находиться в одной комнате или в разных и общаться с помощью переговорных устройств. Во время разговора один из собеседников симулировал эпилептический припадок. Когда беседа шла один на один, 85% подопытных попытались оказать помощь. Когда в разговоре участвовали еще четыре человека, прийти на помощь готов был только 31% испытуемых.

История чат-бота компании Microsoft по имени Тэй — еще один аргумент в пользу того, что не стоит учить искусственный интеллект по тому, как думает большинство людей. Аккаунт бота в Twitter появился в марте 2016 года. «Чем больше вы говорите с ней, тем умнее Тэй становится», — было написано в профиле. Меньше чем через сутки бот стал писать о любви к Гитлеру и ненависти ко всем, особенно к феминисткам. Компания отключила Тэй на несколько дней, чтобы научить справляться с атаками троллей. Когда бот снова вышел в интернет, он сообщил одному из пользователей, что курит травку перед полицейскими, а затем стал писать сотням тысяч подписчиков: «Ты слишком быстрый. Пожалуйста, успокойся». После этого Microsoft перевела аккаунт в приватный режим, скрыв все твиты.

Отказаться от опроса общественного мнения при создании этики искусственного интеллекта решили в 2017 году в Германии. Это пока единственная страна, где есть официальные этические правила (не имеющие статуса закона) для автономных автомобилей.

Вместе со специалистами министерства транспорта и цифровой инфраструктуры над правилами работали ученые, в том числе глава Института социальных исследований Университета Гёте, руководство автоконцернов Daimler и Volkswagen, члены конституционного суда и главы общественных организаций. Среди прочего, они «строго запретили» в случае неизбежной аварии «выбирать возможных жертв по каким-либо личным качествам (возрасту, полу, физическому и ментальному состоянию)».

При этом на один из вопросов, поднятых в Moral Machine, немцы все-таки ответили: «Те стороны, которые вовлечены в создание опасности при движении, не должны приносить в жертву невовлеченные стороны».

Обсуждение после смерти

Первое правило в составленном немцами списке звучит так: «Главная цель использования частично и полностью автоматизированных транспортных систем заключается в повышении безопасности для всех на дороге». И Юрий Миникин, чья компания Cognitive Technologies сейчас тестирует на улицах Москвы беспилотный трамвай (обкатка беспилотных «КамАЗов» в Татарстане начнется в этом году), считает, что повсеместное использование беспилотников настолько снизит количество ДТП, что не так уж и важно, какое именно разрешение моральных дилемм будет в итоге выбрано.

— Моральная дилемма для беспилотника будет редчайшим случаем. У самого автомобиля морали нет, конечно, он действует по заданным ему критериям. И в данном случае это должен быть критерий минимизации ущерба. Как оценивать ущерб, чтобы его минимизировать, — тонкий момент. Навстречу едет машина, мы не можем узнать, сколько в ней человек. На переходе два ребенка, а вдруг в машине их три? Но эти двое — очевидный факт, а что в машине — неизвестно», — сказал Миникин, добавив, что вопрос «Кого сбивать — бабушку или ребенка?» — зона ответственности законодателей и сертифицирующих органов.

Пока же программисты Cognitive Technologies пишут алгоритмы по ПДД, которые не видят разницы «между ребенком и взрослым в вопросе, кого из них сбивать». И предписывают тормозить в случае опасности — «сейчас, если машина уйдет со своей полосы и собьет старичка, чтобы спасти детей, она нарушит ПДД, то есть водитель будет виноват по закону, даже если поступит правильно с точки зрения морали».

По мнению специалиста, этика роботов появится, когда появятся жертвы: «Вот когда машина первый раз кого-то собьет, начнется обсуждение». Но директор департамента взаимодействия науки, технологий и общества Московского технологического института Петр Левич считает, что заняться этим надо гораздо раньше.

Петр Левич, директор департамента взаимодействия науки, технологий и общества Московского технологического института

Компьютеры «с большими полномочиями» потребуются нам для управления заводами, электростанциями, может быть, даже городами. Например, искусственный интеллект будет руководить работой атомной электростанции. И ему придется принимать сложные решения — допустим, закрыть зону реактора, даже если в ней остались люди, чтобы не допустить больших жертв.

Рассуждая о формировании этики ИИ, Левич с сомнением высказался о том, чтобы учить машину на поступках большинства людей.

— Это снимает некоторую ответственность с автора программы, но не стоит забывать принцип «я плох настолько, насколько плох мой учитель», — заключил специалист.

Несмотря на бесполезность для создания этики роботов, Moral Machine остается ценным источником информации о людях. Так, из 117 стран, участвовавших в опросе, Россия оказалась на 111-м месте по количеству людей, решивших спасти женщин и пожертвовать мужчинами в ДТП. На 105-м, когда предлагали сохранить жизни пешеходов, убив пассажиров. И на 101-м месте среди тех, кто руководствовался принципом «чем больше жизней удастся спасти, тем лучше».

Гораздо чаще других жителей планеты (32-е место) россияне не вмешивались в ситуацию и давали машине ехать прямо при опасности, не сворачивая. Еще, по мнению наших сограждан, те, кто соблюдает ПДД, более достойны жизни, чем те, кто нарушает, — 21-е место из 117. По ответам россияне больше всего похожи на украинцев. И сильнее всего отличаются от жителей Венесуэлы.