Нечастное детство: ЕС разрешит сканировать переписку на предмет насилия над малолетними

Европейская комиссия предложила новый закон по борьбе с сексуальными надругательствами над детьми в интернете. Он позволит странам ЕС требовать от таких компаний, как Facebook (принадлежат корпорации Meta, которая признана экстремистской и запрещена в РФ) и Apple, внедрять системы, которые могут сканировать, обнаруживать и удалять контент с сексуальным насилием над детьми на своих платформах. Для этого личную переписку пользователей будет проверять искусственный интеллект, а затем вживую рассматривать уполномоченный сотрудник. Насколько безопасен такой механизм с точки зрения утечек и ложных срабатываний — разбирались «Известия».

Масштаб проблемы

Только за 2021 год в мире было зафиксировано 85 млн фотографий и видео, на которых запечатлено сексуальное насилие над несовершеннолетними, сообщается в пресс-релизе Европейского союза.

Отмечается, что по сравнению с 2020 годом число подтвержденных случаев сексуальной эксплуатации детей выросло на 64%. Оценка числа таких преступлений в большей степени основана на добровольных сообщениях от сервисов, специализирующихся на эротическом и порнографическом контенте.

В случае принятия закона сбор информации будет четче и объемнее, полагает Еврокомиссия. Правила коснутся онлайн-сервисов, предлагающих услуги в ЕС: мессенджеров, интернет-провайдеров, магазинов приложений и хостингов. Несмотря на положительные намерения экспертов, новые требования уже вызвали шквал критики. Главную угрозу специалисты видят в «тотальном наблюдении» за пользователями.

Подобные обвинения в адрес корпораций уже звучали в прошлом году. Тогда Apple объявила о планах включить обнаружение материалов сексуального насилия над детьми в iCloud Photos и iMessage, но реализация была отложена из-за негативной реакции.

Как работает обнаружение CSAM

Аббревиатура CSAM расшифровывается как Child Sexual Abuse Material («материалы, описывающие сексуальное насилие над детьми»). Это база конкретных изображений, которую собрали организации по защите детей. Фотографии из этой базы или похожие на них и будут искать в соцсетях и цифровых хранилищах.

Технологии обнаружения CSAM обычно основаны на хешировании, поясняют в Еврокомиссии. Каждому изображению из базы данных присваивается уникальный цифровой отпечаток, последовательность символов — хеш. Коллекция таких хешей загружается на платформу или устройство. Фотографии, которые пользователи отправляют друг другу в переписках или загружают в облако, также получают свой хеш. Если в сообщениях промелькнет изображение с детской порнографией, искусственный интеллект выделит его в соответствующую категорию и сопоставит код с уже загруженными. Если они совпадут, то в дальнейшем уже человек сверяет, насколько точна оказалась машина.

Компании, обнаружившие сексуальное насилие над детьми в интернете, должны будут сообщить об этом в специально созданный Центр ЕС. Национальные органы могут обязать удалить контент, если файлы не были быстро удалены самими платформами. Также власти могут приказать провайдерам отключить доступ к фото и видео, которые размещены за пределами ЕС.

Если компания всё же нарушит правила, ей грозит штраф в размере до 6% от глобального годового оборота. Каждая страна — участница ЕС сама принимает решение об объеме выплат.

Уязвимость метода

Критики механизма и самой идеи сканирования данных обеспокоены тем, что закон фактически лишит частной жизни и безопасности миллионы людей, включая детей. К тому же существует вероятность ложной идентификации.

У хеширования действительно есть недочеты. На данном этапе искусственный интеллект обречен совершать ошибки. Когда Apple объявил о грядущем сканировании, IT-специалисты проверили используемый компанией механизм NeuralHash на корректность. Так были выявлены некоторые неточности: по версии алгоритма, две картинки ниже имеют одинаковый цифровой код, при этом они очевидно разные.

Поиск в общедоступной базе данных ImageNet обнаружил и другие несовпадения: одинаковый хеш имели изображения гвоздя и лыжи, а также снимки топора и червя. Более того, айтишники создали искусственные пары картинок. Фотография девочки была изменена так, чтобы ее хеш совпадал с хешем изображения собаки.

Решения на базе искусственного интеллекта почти всегда имеют погрешности. В 2020 году было опубликовано любопытное исследование — 1000 фраз, которые неправильно распознаются голосовыми ассистентами и принимаются ими за обращение. Alexa, например, ошибочно отзывается на созвучные «election» («выборы») и «a letter» («письмо»), а Siri — на «a city» («город») и «hey Jerry» («эй, Джерри»). Более того, в попытке улучшить распознавание слов запись может быть расшифрована и проверена сотрудниками платформы. Результат — фрагменты личных разговоров попадают в журналы компаний.

Политический советник организации EDRi Элла Якубовска в принципе полагает, что нынешние технологии пока не готовы для сложных миссий: «Только посмотрите, насколько изворотливы спам-фильтры. Они присутствуют в нашей электронной почте уже 20 лет, но сколько из нас всё еще получают спам на почту и пропускают настоящие письма? Это действительно показывает ограниченность технологий».

Критика политического характера звучит еще громче: сейчас речь идет о детской порнографии, но раз такой механизм существует, где гарантия, что его нельзя будет перенацелить на другой контент?

Эксперты «Лаборатории Касперского», рассуждая о технологии сканирования, обращают внимание на отсутствие компромисса в данном вопросе: «Претензии правоохранительных органов о сложностях в поимке преступников и сборе доказательной базы из-за повсеместного внедрения шифрования понятны. Опасения по поводу массовой цифровой слежки тоже очевидны. <…> Проблема заключается в том, что общественного договора, определяющего баланс между безопасностью и приватностью, пока нет».

Еврокомиссия, в свою очередь, обещает предотвращать злоупотребление технологиями и, согласно заявлению, будет поощрять только варианты, наименее нарушающие конфиденциальность. Плюс вряд ли расшифровка будет производиться на основе одной идентичной пары. Например, чтобы в Apple «сработала тревога», должны были совпасть 30 фотографий. До этого порога система просто не даст расшифровать набор данных.

Сообщения с грумингом

Таким образом, под действие закона подпадут уже известные материалы CSAM (повторно загруженные фотографии и видео, которые были идентифицированы ранее), новый CSAM-контент, а также сообщения, содержащие груминг.

Груминг — это длительное установление контакта и доверительных отношений с ребенком с целью получения от него материала сексуальногo характера или встречи с целью вступления в половую связь. Часто жертвами становятся дети в возрасте 9–14 лет, отмечает клинический и семейный психолог, основатель Академии безопасности Ольга Бочкова.

— Грумеры хорошо понимают не только детскую психологию, они хорошо знают детские интересы, проблемы, язык и могут общаться на равных. Часто они сидят в детских играх, на форумах, в тематических чатах — там, где как раз обитают дети, — говорит собеседница «Известий».

Что может произойти при такой связи? «Друг» плавно переходит к теме секса, предлагает очень ненавязчиво обменяться фото, поясняет психолог. Если ребенок в какой-то момент отказывается присылать новые фото, незнакомец начинает шантажировать: «отправлю компромат всем твоим друзьям, если не пришлешь новые».

Груминг, таким образом, запускает целый ряд нарушений формирования личности, считает детский психолог Екатерина Маденко. По ее словам, развиваются патологии и расстройства, тормозящие важные психические функции, отсюда и невротические страхи. «Хищник» выдает издевательство и насилие за «норму жизни», о чем ребенок, чаще подросток, даже не подозревает.

Как указывает Еврокомиссия, груминг в сообщениях также будет выявляться. Этим вновь займутся технологии под присмотром человека. Однако анализ текстовых сообщений кажется еще менее прозрачной и точной процедурой, чем поиск CSAM-изображений, опасаются эксперты.

«Пугает то, что, как только вы используете машины, читающие ваши текстовые сообщения, для какой бы то ни было цели, остальные ограничения просто исчезают», — говорит профессор криптографии Мэтью Грин.

Текущий механизм борьбы с CSAM

В настоящее время некоторые онлайн-платформы добровольно выявляют сексуальное насилие над детьми в Сети. Еврокомиссия заявила, что американские компании предоставляют большинство отчетов, которые попадают в правоохранительные органы, а Национальный центр пропавших без вести и эксплуатируемых детей США направляет отчеты, связанные с ЕС, в Европол и национальные правоохранительные органы.

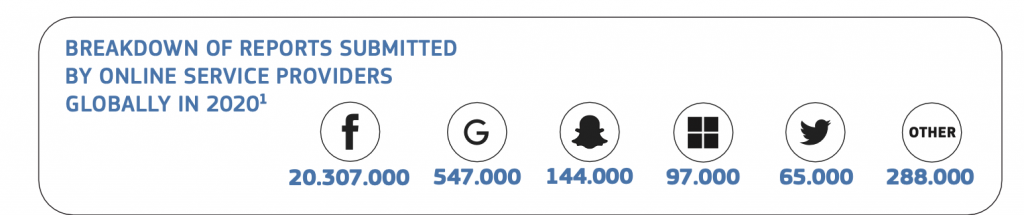

«До 95% всех сообщений о сексуальном насилии над детьми, полученных в 2020 году, поступили от одной компании, несмотря на явные доказательства того, что проблема существует не только на одной платформе», — отметили в Еврокомиссии.

Как уточняют в отчете, добровольных действий недостаточно для эффективного решения проблемы. Необходима четкая и обязательная правовая база.